Primero, me da verguenza tener que instalar un windows, pero para un trabajo lo necesito.

Segundo, no dispongo de ningún otro windows para crear el instalable por USB de Windows 11.

Conclusión: Problemas

Así que vamos a ver que he hecho, que tenemos que tener en cuenta y que problemas me he encontrado.

Para crear un USB para instalar Windows, es necesario que este esté en formato FAT32, si algo sabes de sistemas de archivo, el tamaño máximo para los ficheros de FAT32 es de 4Gb, pero en la ISO de Windows 11, hay un ficherito de marras llamado install.wim que pesa exactamente 4.8Gb.

Mi primera opción ha sido usar el comando dd para tostar la ISO al pincho USB. Nada. Lo he probado primero sobre /dev/sdb y nada, lo segundo sobre /dev/sdb1 y tampoco.

La segunda ha sido usar unetbootin y tampoco. He probado de formatear el pincho USB en fat32, en exFAT y NTFS y nada. El problema es que el fichero install.wim no se pasa completamente al pesar mas de 4Gb.

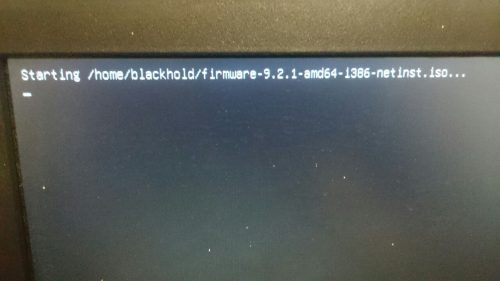

Así que la solución ha pasado por usb el paquete de ubuntu mkusb.

Para ello añadiremos los sources de ubuntu

# vi /etc/apt/sources.list deb http://ppa.launchpad.net/mkusb/ppa/ubuntu focal main # apt-key adv --keyserver keyserver.ubuntu.com --recv 54B8C8AC # apt update # apt -y install mkusb sudo $ sudo mkusb

En debian el root no está configurado para cargar aplicaciones gráficas, para ejecutar un comando como root, será necesario usar el comando sudo.

Seguiremos las instrucciones tal como indica esta …